以下文章来源于公众号:生物设计与制造BDM,作者生物设计与制造

编者按

完全没有想到《科学》主编在2026年的第一天的第一篇社论竟然是这个话题,而且口气很强硬:抵制人工智能垃圾——Resisting AI slop。为什么?我们科学界和出版界应该去想想哈……大家先看看他在社论里表达了几个观点吧。

原文链接

H. Holden Thorp, Resisting AI slop. Science 391(6780):5-5(2026). https://doi.org/10.1126/science.aee8267

今天,谈论任何科学或教育话题都很难不涉及人工智能(AI)——是否允许大语言模型帮助搜索科学论文,甚至是撰写或审查论文本身。在一些最疯狂的猜测中,参与进行科学研究和实验以及审查发表结果的人类将逐渐从这一过程中被淘汰。但是,当这种浮夸的言辞开始飞扬时,我们《科学》杂志试图保持冷静,继续为一份经得起时间考验的、强有力的、人为策划的研究文献做出贡献。

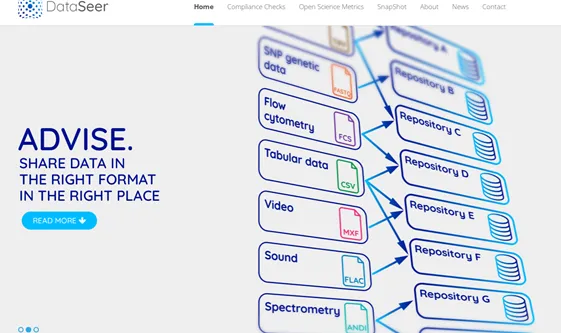

《科学》的最新政策允许在某些过程中使用大型语言模型,而无需任何披露,例如编辑研究论文中的文本以提高清晰度和可读性,或协助收集参考文献。然而,人工智能在此之外的使用——例如,用AI起草文本手稿时——必须披露声明。使用人工智能创造图表数字是不允许的。所有作者必须证明并对所有内容负责,包括通过人工智能生成的内容。《科学》杂志还使用人工智能工具,如identity和proffig,来更好地识别被抄袭的文本或被修改的数字。在过去的一年里,《科学》杂志与DataSeer合作,评估其政策的遵守情况,该政策要求所有已发表的研究文章共享基础数据和代码。初步结果令人鼓舞,在2021年至2024年期间发表的2680篇《科学》论文中,69%的论文共享了数据。为了进一步提高透明度,《科学》杂志在2025年的试点项目中用DataSeer测试过的可重复性清单正在整合到该杂志的协议中。用DataSeer的自然语言处理技术扫描论文并生成预填充的可重复性检查表,要求作者确认条目并根据需要进行修改。

尽管人工智能正在帮助《科学》杂志发现可以纠正的错误或论文中缺少但应该包含的元素,例如支持代码或原始数据,但人工智能的使用对输出的评估需要更多的人力,而不是更少。的确,人工智能使《科学》能够比以前更严格地识别问题,但这些工具生成的报告必须由人来评估。也许从长远来看,对人工智能取代工作的恐慌是合理的,但我仍然持怀疑态度。因为大多数的技术进步并没有导致灾难性的失业发生。

关于人工智能的一个更大担忧是,它在研究论文的制作或审查中的使用可能会降低科学文献的可靠性。这与一些新的努力不同,《科学》禁止审稿人将论文的任何部分放入大语言模型中以生成审稿。然而,《科学》杂志确实允许审稿人使用人工智能来改进文本,只要声明其用途。

科学界对文献腐败的日益警惕已成为科学和学术出版对真相的不懈追求的又一个重要的组成部分。发表经过精心编辑的论文,并接受多人的判断——当涉及到人所犯的错误时,撤回和纠正论文也从未像现在这样重要。作为一种可以在每篇论文中投入更多人力的期刊,《科学》期刊不那么容易受到“人工智能垃圾”的影响,它的贡献也更少,但没有任何系统,无论是人为的还是人工的,可以捕捉到所有的东西。技术可能会使文献的可信度退化,这也说明强化以人类科学经验和专业知识保存的科学记录的价值。

15年前,高等教育似乎也受到了威胁,有人预测,大规模的开放式在线课程将使大学破产, 这并没有发生,但在线课程确实成为了教育的一个重要组成部分,并使大学得以发展,而非萎缩。期刊向网络出版的转变也引发了类似的推测, 它也增加了学术出版的规模。如此类推,接受关于人工智能对科学文献影响的夸大陈述应该等待验证。

像许多工具一样,如果选择正确的使用方式,人工智能或将允许科学界做更多的事情。但(科学)社区需要小心,不要被围绕每个人工智能的产品炒作所迷惑。

结束语:这篇社论提醒我看了《科学》系列期刊近期更新的编辑出版政策中关于“图像和文本的完整性——Image and Text Integrity”的规范指南,值得我们学科与出版编辑在本刊的投稿与审稿的实践中借鉴。